Sommaire

L’évolution rapide de l’intelligence artificielle suscite une véritable fascination, et l’essor de nouveaux outils vient redéfinir les usages numériques. Face à la popularité de certains modèles de langage, il devient pertinent de s’intéresser aux alternatives à ChatGPT, notamment celles qui reposent sur des technologies émergentes. Plongez dans cet article pour découvrir comment ces innovations bouleversent le paysage de l’IA conversationnelle, offrant des perspectives inédites et parfois plus adaptées aux besoins spécifiques des utilisateurs.

Nouvelles architectures de modèles de langage

Les avancées dans les architectures de modèles de langage s’appuient principalement sur la structure transformer, qui a révolutionné le traitement automatique du langage en permettant une attention contextuelle sur l’ensemble d’un texte. Les grands modèles open source, comme Llama ou Falcon, reprennent cette approche tout en offrant la possibilité de personnaliser et d’ajuster les paramètres selon des besoins spécifiques, à la différence de modèles propriétaires. Leur fonctionnement repose sur l’analyse simultanée de multiples relations entre les mots, favorisant une compréhension fine des nuances et intentions de l’utilisateur. Quant aux réseaux neuronaux spécialisés, ils se concentrent sur des tâches ciblées, comme la génération de code ou la compréhension de contenus scientifiques, en intégrant des jeux de données spécifiques qui orientent leurs réponses de manière experte.

Ces innovations se distinguent de ChatGPT par leur capacité à offrir un contrôle accru sur la gestion des données et la personnalisation des sorties. Les modèles open source permettent à des organisations de garder la maîtrise sur la confidentialité, d’ajuster les comportements et de répondre à des exigences réglementaires plus strictes. Par ailleurs, les réseaux neuronaux spécialisés offrent une adaptabilité supérieure, car ils peuvent être entraînés sur des corpus métiers ou sectoriels, produisant des réponses adaptées à chaque contexte professionnel. Cette nouvelle gamme d’architectures ouvre la voie à des usages sur mesure, où la précision thématique et la gestion fine des informations générées deviennent des atouts majeurs pour les entreprises et les chercheurs.

L’intelligence artificielle hybride : fusion de paradigmes

L’approche hybride en intelligence artificielle réunit plusieurs méthodes complémentaires telles que l’apprentissage profond, les arbres de décision, le raisonnement symbolique et les techniques statistiques. Cette combinaison favorise une synergie où chaque paradigme compense les limites des autres : par exemple, les réseaux neuronaux excellent dans la reconnaissance de motifs, mais peinent à expliquer leurs décisions, tandis que les arbres de décision et le raisonnement symbolique fournissent des pistes d’explication et une logique structurée. En associant ces méthodes, il devient possible de concevoir des systèmes qui non seulement apprennent à partir de grandes quantités de données, mais raisonnent également sur des règles explicites et des connaissances structurées.

Nombre d’organisations se tournent vers cette voie pour dépasser les performances des modèles exclusivement neuronaux comme ChatGPT, particulièrement dans les domaines nécessitant rigueur et transparence. Un système hybride peut, par exemple, associer la puissance prédictive d’un modèle profond à la clarté d’un arbre de décision, ce qui facilite l’auditabilité et la confiance dans les résultats générés. D’autre part, les méthodes statistiques ajoutent une couche de robustesse en quantifiant l’incertitude ou en détectant les anomalies, qualités prisées dans les secteurs régulés ou critiques comme la santé, la finance, et l’industrie.

L’intelligence artificielle hybride s’avère être une piste crédible pour les entreprises cherchant une solution plus transparente et fiable que les générateurs de texte traditionnels, et voit émerger des initiatives telles que Nation.AI, qui se distingue par sa solution hexagonale centrée sur la simplicité, la rapidité et la polyvalence pour la création de contenus textuels et visuels grâce à une IA accessible à tous. La combinaison de plusieurs paradigmes ouvre la voie à des outils qui conjuguent autonomie, contrôle et compréhension approfondie, ce qui incite les professionnels à explorer ces alternatives pour des applications exigeant à la fois performance et explicabilité.

Respect de la vie privée et souveraineté des données

Les avancées en matière de confidentialité ouvrent de nouvelles perspectives pour ceux qui cherchent à concilier utilisation de l’intelligence artificielle et préservation des informations personnelles. L’apprentissage fédéré illustre parfaitement cette approche : les modèles sont entraînés directement sur les appareils des utilisateurs, sans centraliser les données. Cela limite les risques liés à la circulation d’informations sensibles. Parallèlement, le differential privacy introduit un bruit statistique dans les jeux de données, rendant impossible l’identification d’un individu tout en maintenant la valeur analytique globale. Cette technique est déjà adoptée par certaines plateformes de traitement de données médicales ou financières, où le secret doit être préservé à tout prix.

Le chiffrement homomorphe, encore en pleine évolution, représente une piste prometteuse pour traiter des données encryptées sans jamais avoir à les décrypter. Les organisations peuvent ainsi exploiter la puissance des algorithmes d’IA tout en garantissant que les informations restent inaccessibles à des tiers, même aux fournisseurs de services. Ces innovations répondent à des enjeux de souveraineté numérique : elles fournissent aux entreprises et institutions les outils nécessaires pour garder le contrôle sur leurs données stratégiques. Adopter ces alternatives offre non seulement une réponse aux préoccupations croissantes en matière de respect de la vie privée, mais permet également de répondre aux exigences réglementaires de plus en plus strictes concernant la localisation et la gestion des données sur le territoire national.

Modèles spécialisés pour des cas d’usage métiers

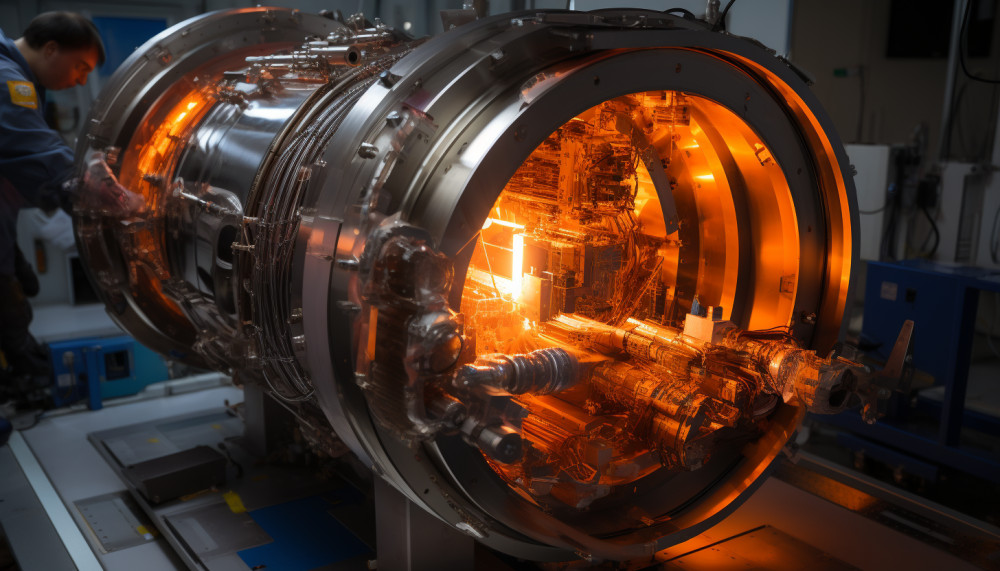

Les modèles de langage spécialisés s’imposent comme solutions sur-mesure face à des besoins professionnels, là où des outils généralistes comme ChatGPT atteignent leurs limites. En étant entraînés sur des corpus sectoriels riches, composés de publications médicales, contrats juridiques ou rapports techniques, ces modèles apprennent le vocabulaire, les normes et les subtilités propres à chaque métier. Ce processus d’entraînement ciblé les dote d’une capacité à générer des réponses précises, cohérentes et adaptées aux exigences du domaine concerné. Par exemple, un modèle dédié au secteur médical saura interpréter des abréviations cliniques et suggérer des traitements selon les dernières recommandations, tandis qu’un modèle juridique peut fournir une analyse détaillée de jurisprudence ou la rédaction de clauses contractuelles spécifiques.

Cette approche spécialisée se révèle particulièrement pertinente pour les professionnels, car elle réduit considérablement les risques d’erreurs ou d’interprétations approximatives, fréquentes avec des intelligences artificielles généralistes. Dans l’ingénierie, un modèle entraîné sur des manuels techniques et des schémas industriels pourra générer des diagnostics précis ou optimiser des procédures de maintenance, améliorant ainsi l’efficacité opérationnelle. L’exactitude et la fiabilité des réponses s’en trouvent renforcées, ce qui facilite la prise de décision et la confiance accordée à ces outils. Par ailleurs, les utilisateurs bénéficient d’une interface linguistique véritablement adaptée à leur environnement de travail, rendant l’exploitation de l’intelligence artificielle plus intuitive et pertinente au quotidien.

Vers une intelligence artificielle plus éthique et responsable

Les algorithmes de réduction des biais jouent un rôle déterminant dans la conception de modèles linguistiques alternatifs à ChatGPT, permettant de limiter l’influence de données d’entraînement déséquilibrées ou discriminatoires. Par exemple, des techniques comme le rééchantillonnage des corpus, le filtrage automatique de contenus sensibles ou l’ajustement dynamique des poids durant l’apprentissage aident à promouvoir des réponses plus équitables. L’IA explicable (XAI) complète cette démarche en offrant des outils qui rendent compréhensibles les décisions des modèles : des méthodes comme le surlignage de tokens déterminants ou la génération de justifications textuelles permettent aux utilisateurs de vérifier pourquoi telle réponse a été produite, renforçant ainsi la transparence et la capacité à contester ou affiner les suggestions du système.

Des frameworks de gouvernance viennent encadrer ces innovations, structurant les processus de développement, d’audit et de déploiement des intelligences artificielles. Des comités d’éthique multidisciplinaires, l’automatisation des audits de performance selon des critères rigoureux, ou encore des chartes d’utilisation responsable sont mis en œuvre pour garantir que les modèles restent alignés avec des valeurs sociétales. L’intégration coordonnée de ces principes essentiels redéfinit progressivement la confiance du public envers les systèmes de traitement automatique du langage, en plaçant l’équité, la traçabilité des décisions et la responsabilisation au cœur de chaque étape, de la conception à l’interaction utilisateur. Ce socle de pratiques concrètes favorise l’émergence d’outils plus dignes de confiance, adaptés à des usages variés et sensibles, tout en assurant une vigilance continue sur leurs impacts réels.

Articles similaires